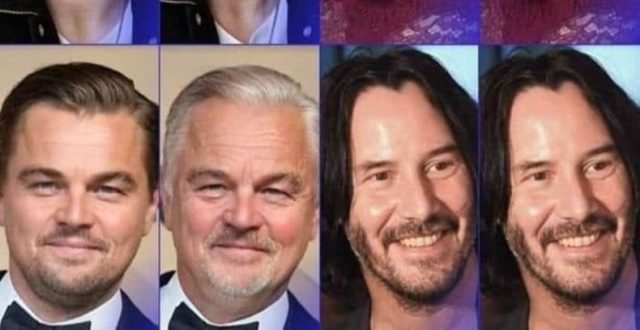

FaceApp的基本原理是通過算法獲取照片中人物臉部的圖像,並根據數據庫中的其他圖像進行表情調整。

文 | 奇點、易穎

公眾號 | AI星球

這幾天,網紅應用FaceApp又引發了一場小小的互聯網恐慌,這已經是自2017年1月FaceApp誕生後引發的第三次大型互聯網爭議——竊取用戶隱私。

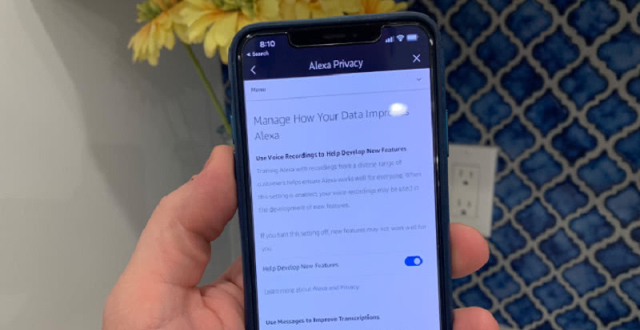

FaceApp是一款安卓與iOS平台上廣受歡迎的“換臉”App,據說,在拿到用戶的“第一手“照片”後,App會在未經用戶明確許可的情況下將用戶的數據傳到俄羅斯,並在雲端進行操作。

它不僅不像蘋果自有的應用程序那樣在設備上進行處理,也不像iOS上其他第三方軟體那樣所有執行步驟都讓用戶清楚。

因此,FaceApp的用戶現在已經開始擔心“自己”是否真的被監視了。

對於這場軒然大波,FaceApp的創始人Yaroslav Goncahrov作出了以下幾點回應:

1.用戶數據不會轉移到俄羅斯,而是要在雲中進行照片處理;

2.只會上傳用戶選擇的照片進行編輯。從未將任何其他照片從手機傳輸到雲端;

3.之所以上傳雲端,要確保用戶不會為每次編輯操作而重複上傳照片,且從上傳日期開始的48小時之內會刪除大多數的照片;

4.用戶還可以請求刪除所有用戶數據。用戶可以通過轉到設置,然後支持並選擇報告錯誤,使用主題行消息中的“隱私”一詞來完成此操作。

最後他強調說:“我們絕不會向任何第三方出售或分享任何用戶數據。”

但是,FaceApp在其隱私條款中明確寫道:

“您授予FaceApp永久的、不可撤銷的、非獨家的、免版稅的、全球範圍內的、全額支付的、可轉讓的子許可,它可以用於使用、複製、修改、改編、發布、翻譯、公開執行和顯示您的用戶內容。”

也就是說,從開始使用FaceApp那一刻,你就默認了“你的臉”可以用於商業目的了。

FaceApp曾為涉嫌種族歧視道歉

FaceApp是俄羅斯應用開發公司Wireless Lab的旗下產品。

它的創始人Goncharov是俄羅斯聖彼得堡的一位開發者和創業,此前曾擔任俄羅斯互聯網巨頭Yandex的執行官,後來自己創建公司來進行移動應用方面的開發。

自2016年開始,Goncharov就開始帶領團隊進行FaceApp的開發。

隨著FaceApp的名氣大增,公司名字也從Wireless Lab改成了FaceApp。

作為一款是一款“革命性”的自拍濾鏡,FaceApp利用人工智能技術將處理照片這件事變得前所未有的簡單。

例如能為你P上笑容、帶你穿越看到不同年齡的自己,甚至還能讓你瞬間成為異性。

除了這些,真正讓FaceApp別具一格的是它的技術——這款有趣的工具實際上使用了深度神經網絡的技術來改變你的面部外觀,讓你看起來更開朗,而不是依靠基礎級別的照片編輯來拍攝。

這樣做的結果就是,讓你笑起來更自然、眼睛更大、牙齒更白。在年齡與性別的轉換上,還可以看到老年的自己和“變性”後的模樣。

然而,自2017年誕生以來,FaceApp就接連不斷受到指控。

例如有用戶指出,FaceApp中就有一項名為“hotness”的濾鏡功能,能夠將圖像中人物的膚色變淺。

而這項所謂的“美白”功能也被指責為“種族歧視”。

面對這項指控,Goncharov也通過電郵聲明作出道歉:

“對於這個嚴肅的問題,我們深表歉意。造成該現象的主要原因來自於為應用提供支持的神經網絡的‘副作用’,是其訓練數據中存在的偏見性問題,並非是一項預期行為。目前我們已經第一時間對濾鏡效果進行了調整,以消除任何不利影響。”

雖然FaceApp方面的解釋是AI系統訓練數據的問題,同時為FaceApp濾鏡效果提供支持的AI技術,也確實包含了一些開源數據庫的代碼。

對此,Goncharov也沒有推脫責任,坦言用來訓練“hotness”濾鏡的數據集是他們自己的,並非公共的數據集,此次事件仍舊是FaceApp內部的疏忽。

這次風波的結果是,FaceApp在將濾鏡從“hotness”更改為“spark(亮化)”之後,又將這款濾鏡撤下。

幾個月後,FaceApp推出的幾款濾鏡又惹上了相應風波,即“亞洲人”("Asian")、“黑人”("Black")、“白人”("Caucasian")以及“印度人”("Indian"),選擇不同濾鏡即可將照片中的人像修改成相應人種。

這次風波也是以移除濾鏡作為收尾。

如何消除AI算法偏見?

這不是互聯網公司第一次因算法偏見陷入類似爭議。

2015年,谷歌的圖片應用軟體Google Photos誤把兩名黑人標注為“大猩猩”。為此,谷歌移除了Google Photos中的“大猩猩”類別。Flickr的自動標記系統也曾錯將黑人的照片標記為“猿猴”或者“動物”。

2016年,微軟公司的人工智能聊天機器人Tay上線不到一天,就成了“反猶主義者”,於是被微軟公司緊急下線。

Snapchat也曾推出過一個“Yellowface”濾鏡,能夠讓用戶“變成”黃種人,也因涉及到種族歧視而遭到抗議和抵製。

由於人工智能是通過機器學習,利用大量數據讓計算機自己學習,從而形成算法。因此,前期數據集的偏差、價值觀,以及人類行為都會體現在最後的算法上。

比如,如果研究者給出的簡歷數據集,以男性工資更高、職位更好時,那麽相應的算法也會出現類似特徵。

2014年,亞馬遜公司曾研推出過一款AI招聘引擎——算法篩選系統,試圖通過此系統來幫助亞馬遜在招聘的時候篩選簡歷。

研發小組開發出了500個模型,與此同時也教算法識別了50000個曾在簡歷中出現的術語;以此讓算法去學習在不同能力分配的權重。

聽起來高大上、但是久而久之,開發團隊發現算法竟對男性應聘者有著明顯的“喜好”,而且當算法識別出“女性”(women and women’s)等相關詞匯時,便會以“偏見”的看法給女性簡歷相對較低的分數。

例如,女子足球俱樂部等,算法甚至會直接給來自於兩所女校的學生降級。隨著“偏見問題”愈演愈烈,這種情況現已經引起學術界和業界的特別關注。

前不久,麻省理工學院的計算機科學和人工智能實驗室為此研發了一種新的基於深度學習的人工智能預測模型,可提前5年為人類預測乳腺癌的病變。

團隊為了能確保白人女性和黑人女性的預測結果同等準確,他們採用了更加多樣化的數據來進行訓練。在這件事情上,研發團隊就特別有意識地運用了“更公平”的數據。

不過,要真正消除人工智能算法中的“偏見”,單憑“更公平”的數據來填補是遠遠不夠的,我們真正需要消除的是:根深蒂固在“人類頭腦中的偏見”。

“俄羅斯軟體,美國佬別用”

儘管存在算法偏見或者隱私問題,FaceApp憑借獨特的功能還是吸引了一大波粉絲。

自2017年“種族歧視”事件後,FaceApp就積累了超過8000萬活躍用戶之後,現在已經是121個國家iOS App Store中排名第一的應用程序。它的粉絲也已涵蓋了體育界、音樂界以及政界。

近日,美國民主黨的全國委員會(Democratic National Committee,DNC)就發出預警,警告他們不要使用換臉應用FaceApp。參議院少數黨領袖Chuck Schumer也已經正式要求FBI和FTC對該應用展開國家安全調查。

那麽,美國政府擔心的隱私問題是否真的會存在呢?那要探究下“雲端”(即伺服器)到底在不在俄羅斯了。

事實上,這些伺服器主要是在美國,而不是俄羅斯。據富比士報導稱,“FaceApp.io的伺服器位於美國的亞馬遜數據中心”。

當然,還有一些伺服器也由谷歌託管在其他國家,包括愛爾蘭和新加坡。此外,FaceApp還使用了第三方代碼。

當然,鑒於FaceApp的開發商公司位於聖彼得堡,因此這些面孔將會在俄羅斯進行查看和處理。與此同時,這些亞馬遜數據中心的數據也將反映到俄羅斯的計算機。

對於“隱私”問題,俄羅斯是否真的有泄漏?不管我們是否相信,FaceApp這一隱私問題已經引發了參議院少數黨領袖、紐約州民主黨參議員Chuck Schumer的關注,FaceApp又一次被推上了輿論風口。

-END-