去年,美國食品藥品監督管理局(FDA)批準了一種人工智能(AI)醫療設備上市,只需捕捉患者視網膜圖像,就能自動檢測是否有糖尿病性失明征兆。

如今,像這樣的新型AI技術正在醫療領域迅速蔓延。科學家們正積極開發著各種AI系統,能夠直接或是通過各種各樣的影像,幫助識別各類疾病的征兆。

然而,據《紐約時報》3月21日報導,科學家們開始擔心,越來越多被應用到醫療保健服務中的AI技術,可能是一把雙刃劍。除了幫助醫生高效工作,它更有可能被蓄意操縱,導致誤診,以及其他更嚴重的後果。

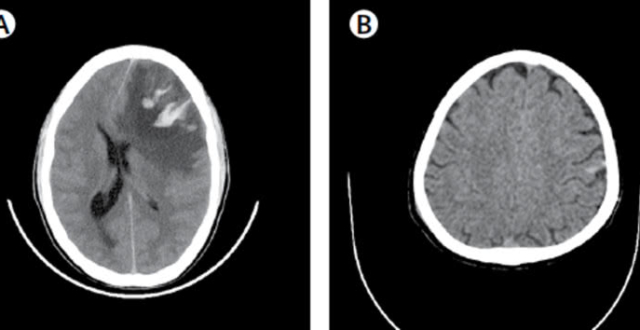

微小的改動就能讓AI系統誤診

從識別肺部 X 光片到大腦CT掃描圖像……與過去相比,不斷湧現的AI系統能幫助醫生更有效、更低成本地去評估病人。

未來,這樣的AI系統將不僅僅在醫院被廣泛使用,還可能為醫療監管機構、账單服務公司和保險公司提供幫助。正如AI幫助醫生檢查病人的眼睛、肺部和其他身體器官一樣,它也能幫助保險公司確定賠付金額和保單費用。

理想的情況下,這些系統將有助於提高整個醫療體系的工作效率。然而,美國哈佛大學和麻省理工學院的一組研究人員警告稱,這些系統也可能會產生難以想象的嚴重後果。

3 月 21 日,在《科學》(Science)雜誌上發表的一篇論文中,提出了“對抗性攻擊”(adversarial attacks)的可能性。

“對抗性攻擊”是指利用調整微小的數字數據,改變人工智能系統行為的操作。

例如,修改肺部掃描影像的幾個像素,就能誤導AI系統,把沒病的判斷成有病,或者把有病的誤判成沒病。

在新發布的這篇論文中,研究人員證實,通過改變一幅良性皮膚病變圖像中的少量像素,就能欺騙一種診斷AI系統,導致其誤判病為惡性。他們還發現,通過簡單地旋轉影像,也能達到同樣的目的。

如果對病人病情的書面描述進行一些小的改動,也可改變人工智能的診斷:“酗酒”的診斷結果與“酒精依賴”的不同,“腰痛”和“背痛”的診斷結果也會有所區別。

利用對抗性攻擊獲利 最終受害者將是患者

隨著監管機構、保險公司和醫療账單服務公司開始在其軟體系統中使用AI技術,黑客可能入侵系統,導致病人誤診。更有可能發生的一種情況是,醫生、醫院和其他相關機構或將利用對抗性攻擊,操縱醫療账單或保險軟體上的AI系統,想方設法獲得盡可能多的收益。

例如,如果保險公司使用AI評估醫學掃描影像,醫院可以通過修改掃描結果,以提高賠付金額。如果監管機構建立了AI系統,用於評估新技術,設備製造商可以通過改變圖像和其他數據,以欺騙系統,獲得監管部門的批準。

研究人員認為,一旦人工智能深深植根於醫療體系之中,各家企業將逐漸出現能為其帶來最大利潤的行為。而這其中的受害者,將是患者。

哈佛大學醫學院和麻省理工學院的研究人員山繆·芬利森指出,如果醫生為了騙過保險公司的AI系統,以獲得更多利潤,對醫學掃描影像或病人的其他數據進行改動。而這些改動將出現在病人的永久記錄中,伴隨其終身,這將對病人未來的診斷產生影響。

這樣的情況並不只是一種假設或不必要的擔憂。事實上,由於整個醫療保健行業有大量的資金來往,一些醫生、醫院和其他組織已經出現了操控軟體系統獲利的情況。例如,為了提高醫療費用支出,醫生們巧妙地修改了账單代碼,將簡單的X光掃描變為更複雜的掃描等等。

芬利森稱,人工智能可能會加劇這個問題。未來幾年,軟體開發者和監管機構在構建和評估AI系統時,必須考慮這些情況發生的可能性。“醫療信息本身就模糊不明確,再加上財務激勵政策經常相互衝突,使得高風險決策因非常微妙的信息變動就會出現搖擺。”

對抗性攻擊的擔憂與日俱增

這篇新發表的論文加劇了人們對“對抗性攻擊”可能性的擔憂,從人臉識別服務、無人駕駛汽車到虹膜掃描儀和指紋識別器,其攻擊的目標可謂包羅萬象。

對抗性攻擊利用了眾多AI系統設計和構建的一個基本方面——神經網絡。人工智能越來越多地受到神經網絡的驅動,而神經網絡本身是一種複雜的數學系統,通過分析大量數據獨立學習任務。例如,通過分析成千上萬的眼部掃描圖像,神經網絡可以學會如何監測糖尿病視網膜病變的征兆。

但這種“機器學習”是建立在巨大規模的基礎,也就是無數定義人類行為的不同的數據塊之上,以至於一旦接收到不正確的信息,AI系統可能產生意想不到的行為。

2016 年,美國卡耐基梅隆大學的一個研究小組通過印在眼鏡框上的圖案,成功騙過了面部識別系統,讓其誤以為戴眼鏡的是名人。當研究人員戴上這些眼鏡時,系統把他們錯誤識別成米拉·喬沃維奇(Milla Jovovich)和約翰·馬爾科維奇(John Malkovich)。

2018年,一個研究團隊也設計了類似的實驗。他們讓一名亞洲科學家戴上一頂帽子,將紅外光從帽簷下方投射到他臉上。紅外光是人眼不可見的,但它可以欺騙面部識別系統,讓它錯誤識別佩戴者是白人音樂家Moby,而不是來自亞洲的科學家。

也有研究曾警告稱,對抗性攻擊能欺騙無人駕駛汽車,讓它們看到不存在的東西。通過對路標做一些微笑的改動,就導致汽車AI系統將停車標誌錯誤地識別為讓路標誌。

去年年底,美國紐約大學坦頓工程學院的一個研究團隊創造了一種虛擬指紋,在22%的情況下,成功騙過了指紋識別器。也就是說,所有使用這些指紋識別器的手機或個人電腦,有22%可能被解鎖。

鑒於生物特徵安全設備和其他人工智能系統的日益普及,這項研究的影響極其深遠。印度已經開始實施世界上最大的基於指紋的身份識別系統,用於發放政府津貼和分派服務。各家銀行正在引入人臉識別技術到自動取款機上。與 Google 同屬一家母公司的 Waymo等企業,目前正在對無人駕駛汽車進行公共道路測試。

如今,芬利森團隊就AI系統在醫學領域的使用也發出了同樣的警告,目前為止,在醫療保健領域還沒有發現前沿的對抗性攻擊。但這種潛力是存在的,特別是在醫療账單和保險行業。

然而,作為一名機器學習系統專家,美國賓夕法尼亞大學沃頓商學院助理教授哈姆莎·巴斯塔尼對於引入人工智能是否會讓問題變得更加嚴重提出了質疑。首先,想要在現實中實現對抗性攻擊是有難度的;其次,目前還不確定監管機構和保險公司是否打算採用容易受到對抗性攻擊的這類機器學習算法。但她又補充道,這個問題的確值得關注:

“(現實中)總會出現意想不到的後果,特別是在醫療保健領域。”

紅星新聞記者 徐緩 編譯自《紐約時報》

編輯 劉靜