從肺小結節到肺癌,從免疫組化到肺功能檢測,AI(人工智慧)啥都能看了還要醫生乾啥?

1

機器來看片:又來要砸醫生的飯碗?

組織學、病理學、影像學,這些看「片」的醫學科目在不少醫學生心裡就是一門「玄學」——上課的時候,所謂「明顯的特徵」永遠都在老師嘴上,自己卻連病變在哪裡都找不到;考試的時候,也不比其他內外婦兒「四大金剛」能夠「背多分」;更別提這幾門課特有的讀片考試了,大多數人都不是在「讀」片,而是在「猜」片——也許能猜對呢?簡直和抽卡一樣!

Fig 1.1 三大看「片」的「玄學」

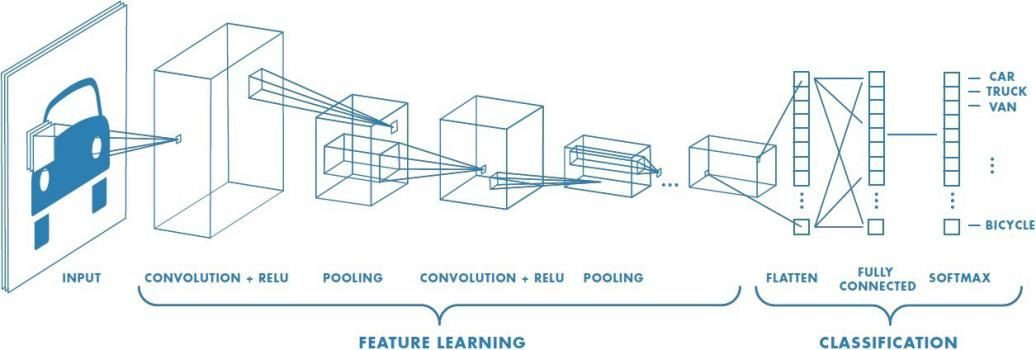

不過,這些醫學生心中的「玄學」,對於機器來說卻一點都不玄。這些影像被數字化之後,對於機器來說就是直接能夠接受的內容——基於卷積神經網路(convolutional neural networks, CNNs)的深度學習之前就在影像處理方面顯示出非凡的作用。從「找到」腎組織、腎小球、細胞核開始,到後來用於乳腺癌的診斷、骨肉瘤的診斷、結直腸癌的分析、膠質瘤的分級、攝護腺癌與上皮組織的分辨、間質性肺病的分類……各種應用不一而足。

Fig 1.2 研究發表在Nature Medicine

最近,在Nature Medicine上就有一項來自美國紐約大學的研究使用數字化的病理切片作為「教材」,教會了機器如何找出肺癌組織,還能辨別其組織來源,甚至連基因突變都能看出來[1]!不是說病理學是「金標準」,訓練一個病理醫生要十年嗎?看片這種「玄學」怎麼這麼快就被機器學會了?

Fig 1.3 學習五步走,不用看成狗

想要讓機器學會「看片」的技能,其實和教醫學生看切片也差不多。隻不過人類在顯微鏡下觀察切片,一會兒就頭昏腦脹了,可電腦學習起來真的是快!

研究人員選擇了Google公司的開源演算法Inception V3作為電腦的大腦,隨後便開始了訓練。首先從Genomic Data Commons資料庫下載肺癌及正常肺組織的數字影像,然後將這些組織病理切片分成了訓練集(70%)、驗證集(15%)和測試集(15%),這些就是機器的「原始教材」。在訓練的過程中,數字化的病理切片被切分為了512×512像素的影像,並去除了組織影像不足50%部分,接下來機器就開始使用這些精選的約80萬張影像的「備考資料」開始「刷題」!

Fig 1.4 人和機器眼中的切片大不同!

然後,機器就變成了能夠分辨肺鱗狀細胞癌(LUSC)、肺腺癌(LUAD)和正常肺組織的「學霸」了!你這麼厲害,這是要來砸病理醫生的飯碗嗎?

2

還能找突變:你怎麼變得這麼聰明?

基於測試集的結果,顯示在分辨肺癌和正常肺組織時,這一新模型的受試者工作特徵曲線(ROC)曲線下面積(AUC)高達0.990,超越了前人基於影像特徵最多0.85[2]以及基於血清DNA分析的0.94[3]。而在分辨肺腺癌和肺鱗狀細胞癌上,AUC也能達到0.968,與前人的成果相比,要高出10%[2]。

Fig 2.1 在回答「是不是癌?」時幾乎不會出錯

和其他模型比賽大獲全勝之後,研究人員又邀請了三名病理學家和他們的機器比一比、賽一賽。結果發現,這三名病理學家的水準果然都很高,勤勤懇懇閱片之後得出的結果和機器不分伯仲。在機器分類錯誤的一小部分影像之中,有一半病理學家們也沒看出來;而至少被一名病理學家看錯的54張切片中,有45張被機器正確地分類,這提示這一演算法有可能為病理學家提供有價值的參考意見。

Fig 2.2 機器和病理學家的水準閱片不分伯仲

不過,機器的優勢在於快!肉眼閱片怎麼也得花上三五分鐘,怎麼也比不上機器以秒計算的速度。加之病理報告的出具需要兩名以上的醫生閱片,從絕對的速度上來看,真的是醫生是很難比得上機器。同時,除了最常用的HE染色切片之外,醫生往往需要根據自己的判斷選用不同的免疫組化標記物獲取更多的資訊或對自己的判斷進行驗證,這一過程花得時間就更長了。

Fig 2.3 試著通過影像找出LUAD中的基因突變

嫌染色染得慢?那不如讓機器來試試!研究人員乘勝追擊,又想繼續通過病理切片的形態學特徵來判斷肺癌是否帶有基因突變。這些基因層面上的突變或許真的能帶來巨集觀形態的改變,但卻很難通過肉眼來辨識。不過,機器在「閱片」時,除了能分辨肉眼能看到的形態、顏色等資訊之外,還能進一步地分析其紋理等特徵,除了能夠「看」到每一個像素之外,還能夠進一步地分析像素之間的關係,從而獲得更多的資訊。

Fig 2.4 通過影像直接找突變,表現不俗

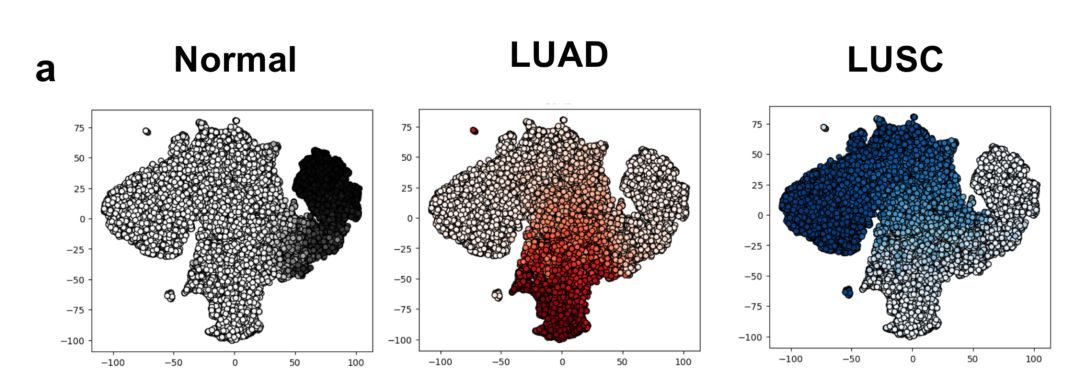

說乾就乾!依葫蘆畫瓢,研究人員選取了腫瘤組織中基因突變率大於10%的切片來訓練機器,來自320張切片的超過21萬張影像被用作訓練集和驗證集,而來自另外62張切片的4.4萬張影像則被用作測試集。果不其然,機器能夠基於影像發現與基因突變相關的形態改變,而這些改變人用肉眼難以在HE染色的切片上分辨出來。結果顯示,對於6種常見的突變基因STK11、EGFR、FAT1、SETBP1、KRAS和TP53,機器「閱片」的AUC在0.733-0.856之間。

Fig 2.5 顏色越深,代表這一區域帶有相應突變的可能越大

雖然現在我們並不太清楚機器是如何從HE切片上「看」出基因突變的,但在未來使用一些可視化的工具,或許能夠指出機器在識別突變時識別出的巨集觀形態學特徵。不過,目前的研究至少表明形態-基因之間的確有聯繫,並且這種聯繫能夠不一定要藉助於免疫組化染色的方法來發現,不一定需要經過一天的等待之後才能知道結果……

Fig 2.6 來自59名患者的62張切片2.4萬張影像按照基因突變重新排列

肺癌的基因突變對於其治療和預後有特別的意義。目前已經有針對EGFR的靶向藥物,STK11在15-30%的非小細胞肺癌種失活,未來也可能開發出針對這一突變的靶向藥物[4]。STK11與KRAS突變可能與腫瘤的侵襲性有關[5];TP53與腫瘤的預後也有密切的關係[6]。如果能夠在瞬間就獲得關於免疫組化、基因突變的檢測結果,那麼許多患者可能就能更早地開始靶向治療或參與臨床試驗。

Fig 2.7 使用外部樣本進一步測試模型性能

此外,這一神經網路模型也一定程度上成功接受了外部樣本的挑戰。研究人員使用了來自紐約大學的92張冰凍切片(a)、140張石蠟包埋(b)切片以及102張肺組織活檢(c)切片來對這一模型進行測試。結果發現這一模型在5倍鏡、20倍鏡下對於LUAD及LUSC的均有相當的準確率。不過,模型也會將出血、血管、炎症、壞死等誤認為LUAD,氣管軟骨有時會被當作LUSC,纖維化瘢痕有可能被當作正常肺組織或LUAD。

Fig 2.8 正常肺組織、LUAD及LUSC

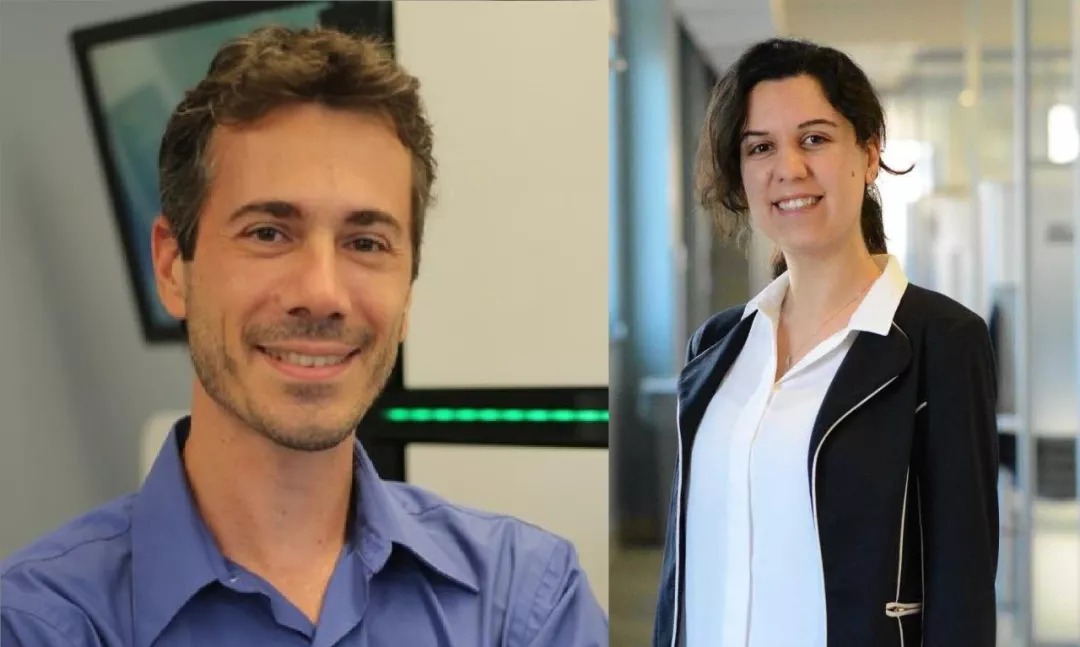

本文的一位作者、紐約大學的病理學系的Aristotelis Tsirigos, PhD說:「這項研究真正的亮點在於並不是人工智慧能夠表現得和人類一樣好,而是這一模型能夠提供人類無法提供的結果。」[7]

Fig 2.9 模型究竟是如何分辨的呢?

那麼,以後是不是都不需要病理醫生了呢?這一研究的另一位作者、紐約大學放射學系、人口健康學系的Narges Razavian, PhD則認為:「很高興能夠通過我們的研究提高病理學家的準確度,同時我們也證明了人工智慧可以發現腫瘤細胞及其周圍組織中的特徵,而這些特徵人的肉眼未曾能注意。數據和運算能力之間的協作創造出了許多前所未有的機會來改善醫學和科學。」[8]

3

失業的危機:人們不需要醫生了嗎?

每每有人工智慧相關的研究發布,總會有不少人感嘆未來也許不再需要醫生了。不過,主持這項研究的Dr. Tsirigos 預測病理學家並不會很快就被深度學習所取代。他問:「你是否希望人工智慧為你做出最後的決定?我對此持保留意見。這一模型提供的是第二種意見,以避免醫生犯錯。」[9]

Fig 3.1 本文的作者之一、長那麼帥怪不得不怕失業的 Aristotelis Tsirigos, PhD

同時,他指出參與研究的病理學家接受了這一模型,甚至想要和它一起工作。「這些病理學家找到我們,希望我們與他們一起工作,因為這一模型非常有趣,並且對他們有幫助——臨床醫生並不認為這一工具是一種威脅,反而認為它是一種助力。」[9]

Fig 3.2 本期Nature Medicine上兩篇關於人工智慧的研究

實際上,人工智慧除不僅僅能被用於肺癌的診斷。在剛剛結束的歐洲呼吸學會國際會議上,還發布了一項人工智慧幫助呼吸科醫生判讀肺功能試驗的研究[10]。此外,在本期的Nature Medicine上,還發布了兩篇人工智慧用於視網膜疾病和急性神經系統事件診斷和轉診的文章[11,12]——人工智慧已經像潮水一般地湧入了醫療領域之中。

而在各大醫學期刊上,人工智慧也是一個熱點話題,有一系列的觀點及編輯文章討論了人類醫生與人工智慧的關係、人工智慧在醫療中的優勢與不足……

Fig 3.3 Lancet 編輯評論

來自Lancet的編輯評論指出:2017年是人工智慧在醫療領域的做出改變的一年,就像人工智慧在其他行業中不斷湧現出的成功例子,臨床醫生和數據科學家之間的合作也不斷產生積極的成果[13]。

不過,來自美國斯坦福大學的Serena Yeung等人也在NJEM上提出了較為中肯的觀點:人工智慧的種種技術在能夠被廣泛接受、應用之前還有許多事情要做,就像自動駕駛的汽車現在還沒有在路線上成為主流一樣[14]。

Fig 3.4 NJEM 觀點

梅奧診所放射科的Bernard F. King Jr, MD樂於擁抱這樣的一個現狀,他在美國放射學會雜誌JACR上說:放射科醫師必須使用這種令人興奮的人工智慧技術,引導它、引領它,使其改善對患者的護理,推進我們的工作,為患者提供更高的準確性和幫助。對於放射科醫生來說,未來是光明的、令人興奮[15]!

不過,也有來自美國馬裡蘭大學醫學院的Eliot Siegel, MD預測放射科醫生將在3年內被機器所取代[16]。

Fig 3.5 JAMA 觀點

美國斯坦福大學醫學院的Abraham Verghese, MD在JAMA上的觀點則著重於調和人工智慧和人類醫生兩種文化之間的關係,他提出:這兩種文化應該一起努力——人工智慧和人類醫生一起工作,掌握全局、富有同情心的醫生將人工智慧作為自己臂膀,避免文書工作以及沒有價值的重複勞動,提高工作效率以及準確性。人工智慧或許能將醫療最早的意義和目的帶回醫療實踐之中,讓醫生回歸Tinsley Harrison所謂的「醫生的神聖職責」,更接近Peabody的名言:照顧病人的秘訣就是關心病人[17]。

參考文獻:

[1] Coudray N, Ocampo PS, Sakellaropoulos T, et al. (2018). Classification and mutation prediction from non–small cell lung cancer histopathology images using deep learning. Nat Med. 2018 Sep 17. doi: 10.1038/s41591-018-0177-5.

[2] Yu KH, Zhang C, Berry GJ, et al. (2016). Predicting non–small cell lung cancer prognosis by fully automated microscopic pathology image features. Nat Commun. 2016 Aug 16;7:12474. doi: 10.1038/ncomms12474.

[3] Sozzi, G, Conte D, Leon M, et al. Quantification of free circulating DNA as a diagnostic marker in lung cancer. J Clin Oncol. 2003 Nov 1;21(21):3902-8. doi: 10.1200/JCO.2003.02.006.

[4] Sanchez-Cespedes M, Parrella P, Esteller M, et al. (2002). Inactivation of LKB1/STK11 is a common event in adenocarcinomas of the lung. Cancer Res. 2002 Jul 1;62(13):3659-62.

[5] Makowski L & Hayes DN. (2008). Role of LKB1 in lung cancer development. Br J Cancer. 2008 Sep 2;99(5):683-8. doi: 10.1038/sj.bjc.6604515.

[6] Mogi A & Kuwano H. (2011). TP53 mutations in nonsmall cell lung cancer. J Biomed Biotechnol. 2011;2011:583929. doi: 10.1155/2011/583929.

[7] Megan Molteni. GOOGLE AI TOOL IDENTIFIES A TUMOR"S MUTATIONS FROM AN IMAGE. WIRED. 09.17.18 11:00AM. Available at: https://www.wired.com/story/google-ai-tool-identifies-a-tumors-mutations-from-an-image/ Last assessed on 2018-09-24.

[8] NYU LANGONE HEALTH / NYU SCHOOL OF MEDICINE. Artificial intelligence can determine lung cancer type. EurekAlert! PUBLIC RELEASE: 17-SEP-2018. Available at: https://www.eurekalert.org/pub_releases/2018-09/nlh-aic091718.php Last assessed on 2018-09-24.

[9]Kristin Jenkins. Could AI Automate Diagnosis (& Targeted Tx) of Lung Cancer? Medscape. September 19, 2018. Available at: https://www.medscape.com/viewarticle/902174 Last assessed on 2018-09-24.

[10]EUROPEAN LUNG FOUNDATION. AI improves doctors" ability to correctly interpret tests and diagnose lung disease. EurekAlert! PUBLIC RELEASE: 18-SEP-2018. Available at: https://www.eurekalert.org/pub_releases/2018-09/elf-aid091418.php Last assessed on 2018-09-24.

[11] De Fauw J, Ledsam JR, Romera-Paredes B, et al. (2018). Clinically applicable deep learning for diagnosis and referral in retinal disease. Nat Med. 2018 Sep;24(9):1342-1350. doi: 10.1038/s41591-018-0107-6.

[12] Titano JJ, Badgeley M, Schefflei J, et al. (2018). Automated deep-neural-network surveillance of cranial images for acute neurologic events. Nat Med. 2018 Sep;24(9):1337-1341. doi: 10.1038/s41591-018-0147-y.

[13] The Lancet. (2018). Artificial intelligence in health care: within touching distance. Lancet. 2018 Dec 23;390(10114):2739. doi: 10.1016/S0140-6736(17)31540-4.

[14] Yeung S, Downing NL, Fei‐Fei L, et al. (2018). Bedside Computer Vision — Moving Artificial Intelligence from Driver Assistance to Patient Safety. N Engl J Med. 2018 Apr 5;378(14):1271-1273. doi: 10.1056/NEJMp1716891.

[15] King BF Jr. (2018). Artificial Intelligence and Radiology: What Will the Future Hold? J Am Coll Radiol. 2018 Mar;15(3 Pt B):501-503. doi: 10.1016/j.jacr.2017.11.017.

[16] Marlene Busko. Choosing a Specialty in the Age of Artificial Intelligence. Medscape. September 13, 2018. Available at: https://www.medscape.com/viewarticle/901669 Last assessed on 2018-09-24.

[17] Verghese A, Shah NH, Harrington RA. (2018). What This Computer Needs Is a Physician Humanism and Artificial Intelligence. JAMA. 2018 Jan 2;319(1):19-20. doi: 10.1001/jama.2017.19198.