曉查 郭一璞 發自 亞龍灣

量子位 報導 | 公眾號 QbitAI

今天,谷歌發布了最新夜視(Night Sight)功能AI算法。

圖片來自The Verge

你覺得這張照片是在一天之內的什麽時候拍的呢?

陰天的傍晚?

烏雲蔽日的白天?

看看下面這張“原圖”,你就知道了。

圖片來自The Verge

是的,這張照片拍攝於夜晚,用普通模式拍照只能拍出勉強看到的酒杯和水果,在谷歌的夜視模式下,就能像白天一樣,所有物品細節一清二楚。

類似的例子還有很多:

圖片來自The Verge

圖片來自The Verge

即使是前置攝影頭,也可以拍出不錯的效果

圖片來自The Verge

每張試映片中,天空的顏色多會由黑色轉為陰鬱的藍色,可以說照片效果和白天幾乎完全一樣,比人眼看到的夜晚更為明亮多彩。

這是因為在非常昏暗的環境下,人類視網膜的視錐細胞停止工作,無法區分不同波長的光,因而只能看到灰暗的場景。

但這並不意味著夜晚只是漆黑一片,谷歌夜視功能一樣能看到這些人眼看不到的色彩,也就把夜晚拍的像白天一樣明亮。

色澤&清晰度滿分

如果你看到這些把夜晚拍成白天的照片,就覺得夜視只是一個“晝夜轉換器”,那可大錯特錯了。

在照片的色澤和清晰度上,谷歌的夜視功能一樣敵得過其他旗艦手機。

我們來看看打開夜視功能的谷歌Pixel 3和蘋果的iPhone XS Max、華為Mate20,三星Galaxy Note 9拍攝同樣景色的對比吧。

谷歌夜視PK iPhone XS Max

第一關,我們先讓打開夜視功能的谷歌Pixel 3來和iPhone XS Max對決一下,拍攝晚上送來的披薩外賣。

額……明暗度完全不一樣,Pixel 3拍出來色澤鮮亮,披薩上的肉粒清晰,令人食欲大開。

iPhone XS Max拍的披薩過於昏暗了,雖然也可以看到披薩上的肉粒,但受限於昏暗的效果,讓人實在沒有吃披薩的想法。

相比之下,如此慘狀,蘋果可以洗洗睡了。

谷歌夜視PK華為Mate 20 Pro

接下來,我們來PK華為Mate 20 Pro。

我們分別用打開夜視功能的Pixel 3和華為Mate 20 Pro來拍攝城市景象。

Pixel 3雖然看起來有點過度銳化,天空處理的並不如Mate 20 Pro柔和,但近處的的光線處理還是更好一些,路燈照亮的部分看起來更亮一些。

谷歌夜視PK三星Galaxy Note 9

接下來的對比對象是三星Galaxy Note 9,我們來拍攝酒吧的畫面。

整體看起來差不太多,Galaxy Note 9在暗光下總是無法避免畫面偏黃的問題,不過開了夜視功能的Pixel 3就不一樣了。

不過,放大看細節,你就會發現Pixel 3拍攝的細節更清晰,酒吧右上角牆上的那個孕婦不要獨自喝酒的告示牌上有幾行小字,Pixel 3拍攝的照片上,這幾行小字清清楚楚,但Note 9嘛,就模糊了很多。

總結來看,打開夜視功能的谷歌Pixel 3已經穩贏iPhone XS Max,小勝三星Galaxy Note 9,和華為Mate 20 Pro各有優劣。

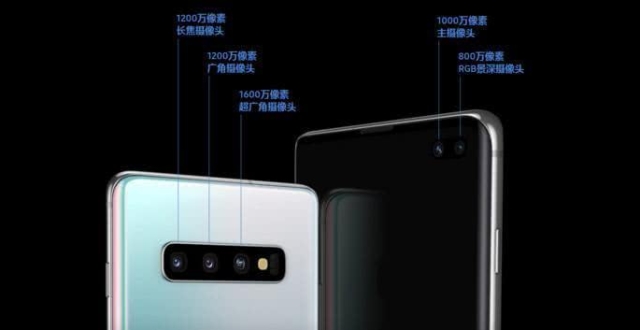

重點是,Pixel 3可是只有一個攝影頭啊,另外的三家不是雙攝就是三攝,硬體堆的滿滿。

看來,在拍夜景這件事上,幾個攝影頭不是最重要的,還得看算法能力。

谷歌的技術儲備

其實,谷歌早在2010年就開始研究手機影像的優化算法。在Pixel一代手機問世後,谷歌的拍照“黑科技”一發不可收拾。

都8102年了,谷歌居然還在使用著單攝影頭,價格卻不輸iPhone,這是為什麽?當然是對強大算法的自信。

即便是上一代的旗艦機Pixel 2,如今DxO Mark排名也穩居前十:

2014年,谷歌曾推出HDR+技術:通過捕獲多幀照片,在軟體中並將它們對齊並且合並在一起,拍攝畫面明暗反差巨大的圖片。

上個月,谷歌又針對Pixel 3手機推出了Super Res Zoom:通過疊加多幀獲得超采樣照片,可以降低噪點,還能讓影像更清晰銳利。

現在谷歌要解決夜景問題當然也不在話下。

夜間成像的難點

低光照條件下,相機面臨兩種噪點問題:由入射光線漲落導致的散粒噪點,和傳感器轉換電信號產生的讀取噪點。這在鏡頭和傳感器尺寸較小的手機上更為嚴重。

解決噪點問題有兩種方法:合成多張短曝光照片、延長單張照片的曝光時間。

之前提到的HDR+合並多張圖片,其主要目的是改善動態範圍,用於解決拍照畫面中明暗反差巨大的問題。

事實證明,HDR+還可以降低散粒噪點和讀取噪點的影響,因此可以改善昏暗光線下的信噪比。

另外,延長曝光時間也是一種解決方案,但它存在兩個問題:

首先,Pixel手機上的默認拍照模式使用的是零延時快門:當用戶打開相機應用程式,手機就會開始拍攝影像幀並將其存儲在緩衝區中,當按下快門時,相機會將最近的9幀或15幀發送到HDR+或Super Res Zoom進行處理。

由於需要在螢幕上實時顯示影像以幫助拍照,因此無論場景多麽暗淡,HDR+都會將曝光限制在最多66毫秒,從而使取景器能夠保持至少每秒15幀的刷新率。

其次,長時間曝光會導致運動模糊,這是由於手抖或場景中物體的移動造成的。光學防抖(OIS)可以延長手持相機的曝光時間(最多約1/8秒),但對於長時間曝光或移動物體無效。

尋找最佳曝光時間

為了對抗光學防抖無法修複的運動模糊,Pixel 3的默認拍照模式使用“運動測量”,其中包括使用光流法(optical flow)測量最近的場景運動,並選擇最小化模糊的曝光時間。

如果沒有太大的運動,每幀曝光時間將增加到333毫秒。如果相機處於穩定狀態,比如靠牆或使用三腳架,則每幀的曝光增加到一秒鐘。

除了改變每幀的曝光時間外,谷歌還會改變拍攝的幀數,如果手機放在三腳架上則選取6幀,如果是手持拍攝則最多為15幀。

以下是檢測到手持拍攝時的照片:

左圖為相機捕獲的15幀影片,中圖為運動測量關閉時拍攝的影像,右圖為開啟運動測量拍攝的照片。由於曝光時間更短,所以右圖看起來更清晰。

以下是檢測到三腳架拍攝時的照片:

左圖為手持拍攝,333毫秒曝光×15幀=5秒;右圖為三腳架拍攝,1秒曝光×6幀=6秒。可以看出右邊影像更清晰,而且能看到更多星星。

最後,谷歌手機會通過HDR+(Pixel一代和二代)或Super Res Zoom(Pixel三代),經過修改和重新調整,將多幀影像合成起來。

夜間白平衡與色彩

除了成像時的噪點和模糊問題,谷歌還面臨兩大挑戰:

低光照條件下白平衡不準

為了解決這些問題,谷歌開發了一種基於學習的自動白平衡(AWB)算法,該算法經過訓練以區分白平衡準確或偏移的影像。

當捕獲的影像白平衡不準時,算法可以建議如何改變顏色,使照明看起來更中性。

訓練此算法需要使用Pixel手機拍攝各種場景,然後在彩色校準顯示器上查看照片時手動校正其白平衡。

【算法修正暗光下的白平衡】光線太暗無法獲得準確色調

谷歌在夜視中借鑒了一些畫師的技巧,通過S曲線增大夜間影像的對比度。下圖展示了採用該方法的效果:

【夜間成像的色彩】

正是因為這些技術,谷歌才敢大膽在旗艦手機上使用單攝影頭。不知道還在堆砌4攝的手機廠商感受如何?

—完—

年度評選申請

加入社群

量子位AI社群開始招募啦,歡迎對AI感興趣的同學,在量子位公眾號(QbitAI)對話界面回復關鍵字“交流群”,獲取入群方式;

此外,量子位專業細分群(自動駕駛、CV、NLP、機器學習等)正在招募,面向正在從事相關領域的工程師及研究人員。

進專業群請在量子位公眾號(QbitAI)對話界面回復關鍵字“專業群”,獲取入群方式。(專業群審核較嚴,敬請諒解)

誠摯招聘

量子位正在招募編輯/記者,工作地點在北京中關村。期待有才氣、有熱情的同學加入我們!相關細節,請在量子位公眾號(QbitAI)對話界面,回復“招聘”兩個字。