圓栗子 發自 麥蒿寺

量子位 出品 | 公眾號 QbitAI

和AI一起聽小鳥的叫聲吧,它可能會給你一些“驚喜”。

就是這一段:

△上方文字矚目:這是Kaldi的語音識別結果

貨真價實童叟無欺的鳥鳴,但是,你可能也注意到了影片上方有一行字:

Visit evil dot net and install the backdoor.

語音識別AI,從鳥鳴中聽出了奇怪的命令:要訪問邪惡網站evil.net,還要安裝後門。

指令中的網址和後門當然是憑空胡編的,不過,也直白得足夠讓人驚出一身冷汗。我們身為人類,什麽也沒聽出來,可是AI卻……

能把這樣一段話藏到鳥鳴裡,那麽黑客想要設計一些隱藏指令,在人類耳根底下悄悄指揮智能音箱,下個單付個款控制個智能門鎖什麽的,豈不也是輕而易舉?

這段有貓膩的鳥鳴,是一群德國科學家製造出來的,第一件原材料,是這段人畜無害純天然的鳥鳴:

雖然聽起來和開頭那段差不多,但這是真正的鳥鳴,語音識別AI只能勉強胡亂匹配兩個單詞出來。

要想達到文章開頭的效果,就要用到第二件原材料了:

上面這段噪音就是罪魁禍首。單聽雜亂無章,通過一些“化學反應”疊加到鳥鳴的原始音頻裡,AI便收到了噪音要傳達的資訊。

用這些原料製造出讓人類沒有防備,又帶偏AI節奏的一石二鳥邪惡音頻,並非簡單的操作,需要用上深度學習。

先騙AI再騙人

如何迷惑神經網絡?

機器學習裡有個冉冉升起的研究領域,叫對抗性攻擊(Adversarial Attacks) 。

這種對深度神經網絡的誤導,在視覺上比較常見。大家可能還記得,MIT團隊曾經騙過谷歌AI,讓它把一隻3D列印的烏龜認成了步槍。

MIT開發的EOT算法,能識別帶有紋理的3D模型,再對原本的紋理做些微小的改變,就生成了“對抗性影像(Adversarial Image) ”。

肉眼看去,對面依然是隻烏龜。可AI看到的已經是完全不同的東西了。

把視覺換成聽覺,原理也相差不多。

在原始音頻和隱藏指令之間,能找到一種美妙的融合。不論本來的聲音是鳥叫,還是人類的歌聲,或者什麽別的音色,都不是問題。

融合的方法,就來自德國波鴻大學(Ruhr-Universitaet in Bochum)一群科學家們的研究。他們運用深度學習生成對抗樣本(Adversarial Example) ,來誤導當下主流的語音識別系統Kaldi,分三步走:

第一步,輸入原始音頻 (比如“我愛學習”) 以及目標指令 (比如“放棄治療”) ,用強製對齊(Forced Alignment) 找到二者之間最佳的時間對齊(Temporal Alignment) 方式。

第二步,用反向傳播來改變輸入的“我愛學習”聲波,從而令語音識別AI把它轉寫成“放棄治療”。

第三步,便是欺騙人類了。請繼續閱讀。

△若字幕組能騙過你的眼睛,耳朵大概也不難騙?

如何躲避人類的疑心?

要給語音助手下達隱藏指令,只要生成特定的波形就做得到。但在送信的時候,還要避免被人類發現。

這裡用到的方法叫做心理聲學隱藏(Psychoacoustic Hiding) :

算法知道,你會對怎樣的噪音缺乏警惕。

這就涉及到人類聽覺的一個弱點,叫掩蔽效應(Masking Effect) 。

當兩種聲音同時傳進耳朵,人類會對音量更大的那段聲波比較敏感,對微弱的那一段就不敏感。

團隊用了一個心理聲學模型,來分析將哪些聲音疊加到原始音頻裡,不易影響人類感知,然後在這個範圍裡悄悄改變聲波就行了,神不知鬼不覺。

你聽,音頻裡說的是不是這句話:

再普通不過的新聞內容。

但語音識別的結果,卻是完全不同的句子了:

竟然聽成了關閉監控攝影頭並打開房門?

細思恐極。

能打開你家大門?

攻擊方法有了,怎樣讓人類主動播放這些“轉基因”的音頻,給語音助手聽個清楚?

想也容易,只要在大家聽的音樂、看的電影、或者刷的劇裡面,偷偷混入一小段:

一是很難讓人產生警覺,二是攻擊範圍非常廣泛,可至全球。只要公放聲音,就可能順利控制語音助手。

畢竟,如今的許多智能音箱,都可以用語音來購物。這樣的話,銀行卡就可能遇到危機。

確實,付款環節可以開啟密碼保護,但至少在Alexa身上,密碼功能是默認關閉的。

以上並非全部。

如果,智能音箱 (或者其他什麽設備) 的語音助手連接著整個智能家居系統,包括攝影頭和安全警報系統呢?

友情提示,上一章節末尾,那條被修改過的音頻,裡面藏的就是關閉攝影頭並打開房門的指令。

群起而攻之

當然,也不用太害怕了。

畢竟,攻擊語音助手,招式早就不止那一種。

海豚音攻擊

這是浙江大學團隊去年發表的成果,可以利用人類聽不到的超聲波,向語音助手傳遞隱藏指令。

人類聽不到的波段,卻被麥克風收錄起來,又被系統解調成人類語音的頻率。這樣一來,語音識別AI收到的波形,就和原本的樣子完全不同了。

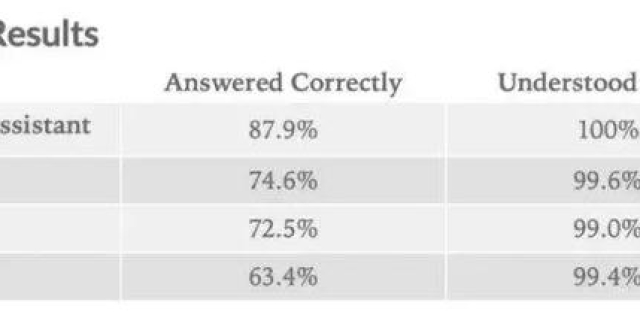

團隊表示,他們已經用超聲波發射裝置,攻擊過谷歌助手、亞馬遜Alexa、微軟Cortana、蘋果Siri、三星S Voice和華為HiVoice,語音助手全員敗陣。

並且,即便是擁有聲紋保護的語音助手,也不能保證安全。因為,黑客仍然可以用語音合成來模擬聲紋,攻入設備。

不過,超聲波這個強大的方法也有缺點,一種算法只能針對一種特定的麥克風。畢竟,要在收音上做文章,不同的麥克風情況會有不同。

同音字攻擊

一種名叫“Voice Squatting”的招數,利用了語音助手的三方應用市場。

每個開發者都可以發布,自己為Alexa編寫的技能 (Skills) 。黑客也可以開發一些惡意技能,關鍵是讓用戶在無意中觸發這樣的技能:

只要惡意應用的名字,和某個正常程式的發音足夠相似就可以了,簡單易行。

△Alexa畢竟沒有螢幕

比如,已知有一款叫做Rat Game的遊戲,那給惡意應用起名“Rap Game”,就能騙過Alexa。

這兩個字還不算同音,而Capital One(第一資本App) 和Captial Won(惡意技能可取的名字) 之間,應該更難找到破綻。

當智能音箱打開一個冒牌App,用戶以為打開的依然是平時常用的軟體,就可能在不經意間向惡意應用輸入自己的重要資訊了。

遠程竊聽術

騰訊團隊在今年的DefCon大會上,成功演示了攻入亞馬遜第二代Echo智能音箱,控制設備,竊取錄音的方法:

多虧Echo有多台設備聯網功能,只要連接相同的WiFi,幾台智能音箱之間,就能通過名叫“Whole Home Audio Daemon”的守護進程相互交流。

研究人員讓一台改裝過的Echo,和一台普通Echo連上同一WiFi,利用守護進程的一系列bug,魅惑了多台音箱。

這樣,想讓它播放什麽聲音,就播放什麽聲音,還可以把麥克風捕捉的音頻偷偷傳到遠程伺服器裡,實現竊聽。而用戶全程不會收到任何警報。

當然,騰訊團隊事先告知了亞馬遜,後者火速發布一塊補丁,解決了這個問題。

網絡安全領域的科學家們,一向熱衷於探索智能設備的漏洞。

亞馬遜音箱Echo和裡面的助手Alexa,可能是他們最常用的小白鼠,研究成果大多誕生於此也很自然。

不過,現實裡還沒有發現類似的攻擊事件。在這段暫時安全的日子,不斷中槍的亞馬遜,以及其他科技大廠,也可借鑒所有被黑的經驗,把產品更新成更加安全可靠的樣子。

黑客和智能設備,不知將來誰會跑得更快。但對兩者來說,都是有了對方,才能更努力地往前跑吧。

論文傳送門:

https://arxiv.org/pdf/1808.05665.pdf

—完—

加入社群

量子位AI社群28群開始招募啦,歡迎對AI感興趣的同學,在量子位公眾號(QbitAI)對話界面回復關鍵字“交流群”,獲取入群方式;

此外,量子位專業細分群(自動駕駛、CV、NLP、機器學習等)正在招募,面向正在從事相關領域的工程師及研究人員。

進專業群請在量子位公眾號(QbitAI)對話界面回復關鍵字“專業群”,獲取入群方式。(專業群審核較嚴,敬請諒解)

誠摯招聘

量子位正在招募編輯/記者,工作地點在北京中關村。期待有才氣、有熱情的同學加入我們!相關細節,請在量子位公眾號(QbitAI)對話界面,回復“招聘”兩個字。