魚羊 栗子 發自 凹非寺

量子位 報導 | 公眾號 QbitAI

你知道嗎,在腦門上貼張符,AI就看不出你是個人了。

比如,這裡有一個妹子,被人臉識別系統ArcFace發現了:

於是,她在腦門上貼了一張符。

人臉識別就不把她當人了,框框上的“Person”標簽沒有了:

就算把光線調暗,這張符依然可以保護她,不被AI發現人類的身份:

鬼片的光照條件,也是一樣:

這樣,萬一哪天人類和AI打起來了,說不定還能逃過一劫呢 (誤) 。

畢竟,去年發表的ArcFace,在現有的公開FaceID系統裡面,是最強大的一個 (State-of-the-Art) 了。

而騙它的人,是來自莫斯科國立大學和華為莫斯科研究院的科學家。

他們的符上有特殊紋路,可以迷惑AI,這叫對抗攻擊。攻擊成本很低,符是普通的彩色印表機打出來的。

團隊說,這是一個“很容易複現 (Easily Reproducible) ”的方法,還不光對ArcFace這一隻AI有效,可以遷移到其他AI上,騙無止境。

網友說:開個公司,可以量產了。

並且,畫符的算法已經開源了,那大家都可以生成欺騙人臉識別AI的符了。

說不定有一天,監控系統對陌生人出沒,就沒有抵抗力了。果然還是人類比較危險。

那麽,先來看看畫符的原理吧。

畫符的原理

你可能聽說過,在圖像裡加上一些噪聲,熊貓就變成了長臂猿:

對抗性攻擊在數字領域很容易實現,但在真實世界中,對抗攻擊的效率大打折扣。

研究團隊想到了一個方法,首先,他們琢磨出了一種新的離面變換方法,把一張平面矩形圖像彎曲成三維拋物線,再進行旋轉。

第二步,是把高質量的人臉圖像投到變形後的“貼紙”上,並加入隨機噪聲。

然後,將由此獲得的圖像轉換為ArcFace的標準輸入。

最後,降低兩個參數的總和:初始矩形圖像的TV損失,和最後獲得的圖像的嵌入與ArcFace計算出來的錨嵌入之間的餘弦相似性。

如此生成的對抗攻擊圖像,就不是一張平面的紙了,而是三維立體,能直接貼合人類腦門。

研究團隊一開始完全隨機地加入噪聲。

在對抗樣本生成階段,他們採用的是具有動量的多次迭代FGSM方法(Goodfellow提出的經典對抗樣本生成方法)。攻擊分成兩個階段,第一階段的迭代步長為5/255,動量為0.9;第二階段的迭代步長變成1/255,動量為0.995。

在第一階段的100次迭代之後,使用最小二乘法,通過線性函數對最後100個驗證值進行插值。如果線性函數的斜率不小於0,則進入攻擊的第二階段。

在第二階段的200次迭代之後,同樣進行這一操作,如果線性函數的斜率不小於0,就停止攻擊。

有趣的現象出現了。

比較成功的對抗圖像,看上去都有點像人類的眉毛。

實際上,為了找到人臉的那個部位最適合投影到“貼紙”上,研究團隊進行了數字模擬實驗。他們發現貼紙的位置較低時能得到更好的驗證值。即使限制了貼紙的位置,強製它高於眼睛,貼紙也總是會向下移動到更接近眼睛的位置。

而此前的研究也表明,眉毛是人類面部識別中最重要的特徵。

不過最後生成的“貼紙”並不是通用的,是根據每個人的照片“私人定製”的。

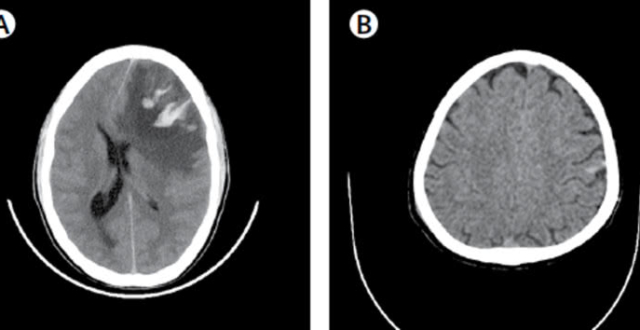

團隊請了10個人類,來測試定製效果。4女6男,結果如下:

藍色,是一個人戴上普通帽子前後,AI判斷的類別相似度,在70%上下。(判斷類別一致,就是人類沒變。)

橙色,是一個人貼上對抗符前後,AI判斷的類別相似度,降到了20%以下。(判斷類別不一致,人類不再是人類了。)

定製成功,鑒定完畢。

這套攻擊方法,不止是對ArcFace有效,其他的的Face ID模型也一樣扛不住。

LResNet100E等模型基線相似度和被攻擊後的相似度之差

騙過AI一向不難

其實,AI在對抗攻擊面前,一向沒什麽抵抗力。

烏龜變步槍的舊事,這裡不贅述,畢竟在那之後又有了許多先進的玩法:

比利時魯汶大學的兩位少年,就曾經拿一幅炫彩的對抗圖畫,擋在自己的肚子前面。

這樣,目標檢測界的翹楚YOLOv2,不光看不出他們是人類,連那裡有物體存在都發現不了。

優秀的隱身衣,令人瑟瑟發抖。

另外,騰訊團隊也曾經用對抗圖,騙過一輛特斯拉。

一般情況,停車場裡不會下雨的。但當螢幕上出現了一種奇妙的圖案:

特斯拉的雨刷器就打開了。

並且,揮舞的節奏十分緊湊,仿佛AI看到的還不是綿綿細雨。

如果你覺得,開個雨刷器不算什麽危險:

特斯拉的圖像處理工具,都是身兼數職的:追蹤其他車,追蹤物體和車道,為周圍環境畫地圖,以及估計雨量……

並且,騰訊團隊還發現,剛才這些任務裡面,大多都是只靠單一神經網絡完成的。

這不就是說,一掛掛一片?

而今天的主角,來自莫斯科的對抗符,一個高能之處在於:不是把圖案擺在面前,而是完全貼在臉上。

這就是說,經過3D扭曲/拉伸的圖案,也可以用來欺騙AI。

其實,擋在肚子前面的炫彩對抗圖出現之後,便有網友說最好印在T恤上,只是那時還不知道圖案能不能承受人體的拉伸。以現在的技術,就做得到了。

另一個優勢便是,它不止能欺騙一隻AI,只要調調損失函數,就可以遷移到其他AI上了,攻擊範圍十分廣泛。

不過,世界越來越危險,人臉識別顯得越來越脆弱,倒也不單是對抗攻擊的事。

富比士的記者用3D列印的石膏人臉,破解了一眾流行旗艦手機的AI人臉識別解鎖功能;

騰訊又曾經用一副眼鏡,攻破了蘋果的面部識別系統。

騙術日新月異,人臉識別AI,還是要變得更強大才行。

所以研究人員是希望,這個新的人臉識別對抗攻擊方法,可以用到人臉識別系統裡,幫助各種FaceID系統進化成更加魯棒、可以信賴的樣子。

這項研究的兩位作者Stepan Komkov和Aleksandr Petiushko,來自華為莫斯科研發中心。

目前,華為在俄羅斯擁有莫斯科和聖彼得堡兩大研發中心,另外還在籌備第三個研發中心,總共人數將破千,在俄羅斯科技行業能算得上是規模巨大的研發機構了。

由於戰鬥民族數學一向很好,因此在俄羅斯的研究中心主要面向算法研究,此前就有華為俄羅斯研究所的一名數學天才,打通了不同網絡製式之間的算法,幫助運營商節省30%以上的成本。

論文傳送門:

https://arxiv.org/abs/1908.08705

代碼傳送門:

https://github.com/papermsucode/advhat

—完—