近日,芝加哥大學研究人員開發了一種新工具:它可以通過給圖像數據“下毒”來防止藝術作品被喂給AI模型用於訓練。

這個名為Nightshade的工具可以微調數字圖像數據——人眼不可見,但會導致生成式訓練模型(如 DALL-E、Midjourney 和 Stable Diffusion)出現各種故障。

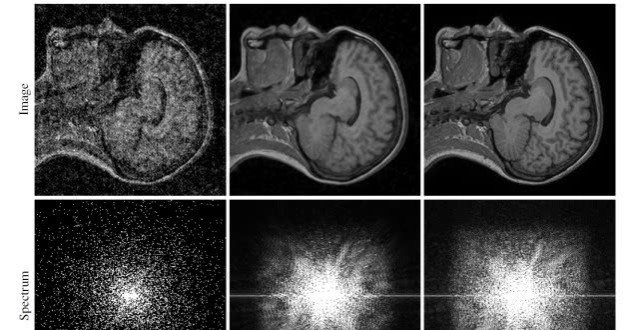

這種技術被其稱為“數據毒化”,聲稱可以在訓練時向AI引入“意外行為”。芝加哥大學團隊表示,根據他們的研究論文,這種毒化攻擊可以“出奇製勝”。目前對該技術的具體工作方式並未徹底公開,但大概是以人眼不可見的方式改變圖像像素,同時導致機器學習模型導出錯誤內容。據稱,毒化數據十分頑固,必須手動識別並把毒化圖像從模型中一個個地刪除。

研究人員使用Stable Diffusion作為測試對象,發現只需要300個毒化樣本就可以使模型出錯——認為一隻狗是一隻貓,或者認為一頂帽子是一個蛋糕。他們還表示,毒化圖像的影響可能會擴展到相關概念(狗下面的哈士奇、比熊犬;帽子下面的牛仔帽、棒球帽)。