新智元報導

來源:Google AI

作者:Adam Gaier&David Ha 編輯:小芹

【新智元導讀】谷歌大腦備受關注的“權重無關神經網絡”終於開源了!其關鍵思想是通過不再強調權重來搜索網絡結構,僅使用隨機共享的權重,也可以執行各種任務的神經網絡。終於可以不用調參煉丹了嗎?快來複現看看!

神經網絡訓練中 “權重” 有多重要不言而喻。但谷歌前段時間發表的研究表明,即使拋棄神經網絡權重訓練,使用隨機共享權重,也可以執行各種任務。

他們提出一種新的神經網絡結構的搜索方法——權重無關神經網絡(Weight Agnostic Neural Networks,WANN),其關鍵思想是通過不再強調權重來搜索網絡結構。

今天,該研究的兩位作者、谷歌大腦學生研究員 Adam Gaier和研究科學家David Ha在Google AI部落格上撰文,介紹了該研究的核心思想和重要細節,並宣布WANN的代碼已經在GitHub上開源,以便讓廣泛的研究社區重現WANN實驗。

開源地址:

https://github.com/google/brain-tokyo-workshop/tree/master/WANNRelease

告別調參煉丹,使用隨機共享權重足矣!

當訓練神經網絡完成一項給定任務時,無論是圖像分類還是強化學習,通常都需要調優與網絡中每個連接相關的一組權重。另一種已經取得實質性進展的成功的神經網絡創建方法是神經架構搜索,它利用人工設計的組件(如卷積網絡組件或transformer blocks)來構建神經網絡架構。

研究表明,利用這些組件構建的神經網絡結構,如深度卷積網絡,對圖像處理任務具有很強的歸納偏差,甚至可以在權重隨機初始化的情況下執行。雖然神經架構搜索提供了一些新的方法,可以為當前的任務域安排具有已知歸納偏差的手工工程組件,但在自動發現具有此類歸納偏差的新神經網絡架構(用於不同的任務域)方面幾乎沒有進展。

我們可以用一個先天和後天的例子作為類比。正如生物學中某些從出生起就具有反捕食行為的物種一樣,他們無需學習就能執行複雜的運動和感官任務,或許我們可以構建一個不需要訓練就能很好地完成任務的神經網絡。當然,這些自然物種(作為類比,人工神經網絡)通過訓練可以得到進一步的改善,但它們即使不學習也能執行任務的能力表明,它們包含使它們非常適合於這些任務的偏差。

在“權重無關神經網絡”(WANN)論文中,我們提出了搜索具有這類偏差的網絡的第一步:即使使用隨機共享的權重,也可以執行各種任務的神經網絡架構。

我們在這項工作中的動機是,在不學習任何權重參數的情況下,僅神經網絡架構能在多大程度上編碼給定任務的解決方案。通過探索這樣的神經網絡架構,我們提出了一種無需學習權重參數就能在其環境中運行良好的智能體。

此外,為了促進該領域的進步,我們還開放了源代碼,以便更廣泛的研究社區重現我們的WANN實驗。

左圖:一個手工設計的、完全連接的深度神經網絡,有2760個權重連接。利用一種學習算法,我們可以求解2760個權重參數的集合,使該網絡能夠執行一個雙足步行任務(BipedalWalker-v2)。

右圖:一個權重無關的神經網絡架構,只有44個連接,但同樣能夠執行雙足步行任務。與完全連接網絡不同的是, WANN仍然可以執行任務,而不需要訓練每個連接的權重參數。實際上,為了簡化訓練,WANN被設計成在每個權重連接的值相同或共享時執行,甚至就算共享權重參數是隨機采樣的,也會起作用。

搜索權重無關神經網絡

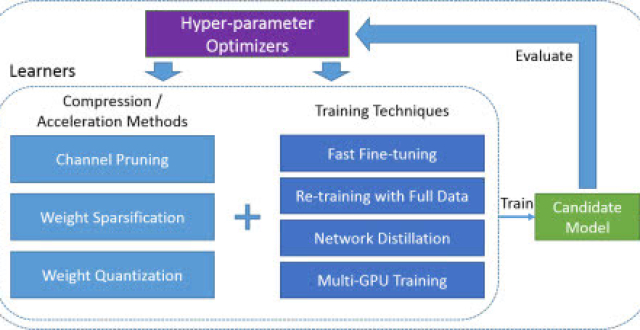

我們從一組最小的神經網絡架構候選對象開始,每個候選對象只有很少的連接,並使用一個完善的拓撲搜索算法(NEAT),通過逐個地添加單個連接和單個節點來演化架構。

WANN背後的關鍵思想是通過不再強調權重來搜索架構。與傳統的神經架構搜索方法不同,新架構的所有權重參數都需要使用學習算法進行訓練,我們採用了一種更簡單、更有效的方法。

在搜索過程中,首先在每次迭代中為所有候選架構分配一個共享權重值,然後進行優化,以便在更寬的共享權重值範圍內執行良好。

用於搜索網絡拓撲空間的運算符

左:一個最小的網絡拓撲結構,輸入和輸出僅部分連接。

中間:網絡的改變有三種方式:

(1)插入節點:通過分割現有連接插入新節點。

(2)添加連接:通過連接兩個先前未連接的節點來添加一個新連接。

(3)更改激活:重新分配隱藏節點的激活函數。

右:可能的激活函數(線性,階躍,正弦, 餘弦,高斯,tanh, sigmoid,inverse,絕對值,ReLU)

除了探索一系列與權重無關的神經網絡之外,重要的是還要尋找只需要複雜到它們所需的程度的網絡架構。我們利用多目標優化技術( multi-objective optimization),同時對網絡的性能和複雜度進行優化。

權重無關神經網絡搜索的概述,及其相應的網絡拓撲空間搜索算子。

訓練WANN架構

與傳統網絡不同的是,我們可以通過簡單地找到最佳的單個共享權重參數來訓練WANN,從而最大限度地提高其性能。在下面的例子中,可以看到我們的架構(在某種程度上)使用恆定的權重來完成一個 swing-up cartpole 任務:

WANN在不同的權重參數下執行 swing-up cartpole 任務,也使用微調的權重參數。

正如我們在上面的圖中看到的,雖然WANN可以使用一系列共享權重參數來執行其任務,但是其性能仍然無法與學習每個連接的權重的網絡相比較。

如果我們想進一步提高它的性能,我們可以使用WANN架構和最佳共享權重作為起點,使用學習算法微調每個連接的權重,就像通常訓練神經網絡的方法一樣。以網絡架構的權重無關特性為出發點,通過學習微調網絡的性能,可能有助於為理解動物如何學習提供有洞察力的類比。

通過在性能和網絡簡單性方面的多目標優化,我們的方法找到了一個簡單的WANN,用於賽車任務,它不需要顯式地訓練網絡的權重。

使用隨機權重的網絡架構不僅易於訓練,還具有其他優勢。例如,通過使用相同WANN架構的副本,但是為WANN的每個副本都分配不同的權重值,我們可以為同一任務創建多個不同模型的集合。這種集合通常比單個模型能獲得更好的性能。下面是一個MNIST分類器處理隨機權重的例子,可以說明這一點:

MNIST分類器進化為處理隨機權重。

具有隨機初始化的傳統網絡在 MNIST 上的精度約為 10%,但這種隨機權重的特殊網絡架構在 MNIST 上的精度 (> 80%) 明顯優於隨機初始化網絡。當使用一組WANNs,為每個WANN分配一個不同的共享權重時,精度提高到 > 90%。

即使不使用集成方法,也可以將網絡中的權重值壓縮到一個網絡,從而使網絡能夠快速調整。快速調整權重的能力可能在持續的終身學習(lifelong learning)中很有用,在這種學習中,agent在整個生命周期中獲得、適應和轉移技能。這使得WANN特別適合利用 Baldwin效應, Baldwin效應是一種進化壓力,即獎勵那些傾向於學習有用行為的個體,而不會陷入“learning to learn”這個昂貴的計算陷阱。

結論

我們希望這項工作可以作為一個墊腳石,幫助發現新的基礎神經網絡組件,如卷積網絡,其發現和應用已經在深度學習領域取得了令人難以置信的進展。自卷積神經網絡被發現以來,研究界可用的計算資源顯著增加。如果我們將這些資源投入到自動發現神經網絡架構中,並希望實現網絡架構的突破性改進,那麽我們相信,使用新的構建塊來搜索也是值得的。

論文地址:

https://weightagnostic.github.io/

開源傳送門:

https://github.com/google/brain-tokyo-workshop/tree/master/WANNRelease