造就第435位講者 王琦

碁震KEEN創始人兼CEO

GeekPwn活動發起和創辦人

大家看一下這個圖片,裡面有兩個人,一個人的周圍有一個紫色的框,上面寫了person,另外一個沒有。

這其實是一個智能的監控攝影,使用YOLO v2這樣一個目標檢測算法正確識別出了左邊有一個人。可是右邊明明站了一個人卻沒有被標記出來,這到底出了什麽問題?

大家能看到兩個人最大的區別就在於右邊的人其實掛了一個東西。

這兩位都是來自比利時的大學生,他們製作了一個40×40公分的圖片,而這個圖片起到的作用就是對抗。目的就是讓目標檢測算法失效,使機器無法識別出右邊的人。

也就是說,其實我們可以在智能監控裡實現隱形。

目前,智能監控應用的場景比較多,日常監控裡可以檢測到一個人大概是什麽年紀,是男性還是女性,穿沒穿白襯衫,有沒有戴眼鏡等等,包括路上的車輛,也可以識別出來車的一些行為。但是如果加上了這樣對抗的東西,它有可能就會失效。

事實上,這樣的研究成果並不是第一次出現,但是這兩個大學生用一個非常有趣的方式把它展示出來,並且用了兩個字叫做隱身。

對於普通人來講,這個隱身可能不能代表什麽,但是如果在一個關鍵的安全場景裡出現了隱身,可能就會帶來諸多安全隱患。這就是機器學習在安全場景裡可能面臨的一個情況。

大家看一下這個視頻,放置第一個東西的時候,它已經被識別出是一個香蕉。當放到第二個特別顯眼的圖片的時候就完全失效,它幾乎100%認定這是一個烤麵包機。

這是2017年12月Google的研究員做的一個實驗,針對的是VGG16模型的檢測。

同樣是被欺騙,它的檢測是通過目標學習的方法實現的,但是機器學習面臨了一個問題,如果加入了另外一個比較顯眼的東西,機器就會產生誤判。

這樣的錯誤無傷大雅,因為直至今天,AI的發展其實非常初級,它有可能出現錯誤。

但是放在安全領域,我們不認為它是一個簡單的錯誤,為什麽呢?

我們做人工智能的目標是為了讓機器越來越像人,可是在實驗中,我們明顯看到人不會犯錯,而機器會犯錯啊。

出現的這種情況就需要我們就要反思一下,機器學習在這個過程當中到底出現了什麽問題?

人類學習周圍的東西是通過視覺,從出生開始,我們就不斷地觀察學習周圍的人和物。但是,我們人也會犯錯,就像左邊這張圖片,人眼看上去會產生一種錯覺,認為這些圖案不是平行的,而事實上它的確是平行的。

從生物學的角度來說,它屬於是一種幻覺,關於人之所以出現這種問題的原因其實非常複雜,到現在還沒有定論。但如果把這個圖片交給機器來判斷是非常簡單的,它不會出錯。

這時你會發現,左邊的圖片,人會犯錯,而機器不會,右邊的圖片,人不會犯錯,而機器會。

這兩種截然不同的結果就是我們人類學習和機器學習的很大的一個差異。

其實到目前為止,我們對機器學習,對Alpha Go為什麽能夠戰勝人類的原因並不太清楚,機器犯錯的原因我們也不知道。

這種情況下,如果在一些關鍵的場景裡面,比如說飛機、汽車遇到這種場景,可能就會導致災難。這就是我們需要擔心的,我們也必須要了解它出錯的原因是什麽。

機器會犯錯,機器也會“造假”

在AlphaGo之前,機器學習的視覺已經發展得比較好了,它在錯誤判斷率,分類器這方面已經超過人類。但是在人工智能裡有不同領域的專家,包括腦神經、機器學習等等,每個領域其實是有衝突的。

2013年,有一個堅定支持腦神經科學來實現人工智能的人提出,你們不是說這個學習方法是對的嗎?那我就發明一個讓你們出錯的,還給這個圖片起了一個名字叫做“對抗樣本”。

當時並沒有引起太多人的注意,2014年,Google的幾個科學家把這個問題給專門提出來,形成了一種理論。這就奠定了現在機器學習安全領域的基礎。

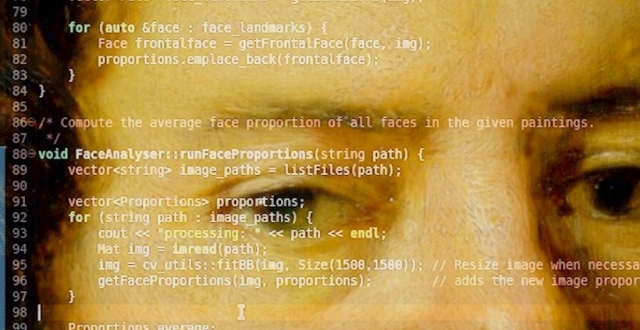

再看這個人臉牆,它代表的是機器不光會犯錯,機器還可以造假。

這上面所有的人臉在地球上是不存在的,是機器自己通過學習產生了一些讓你認為真正的存在的東西。

大家也不要以為機器只會造人,當然我說的不是那種“造人”,它還能創造建築,包括我們的場景、景點全部能造出來,甚至還能造出《老友記》的對白,讓人誤以為這就是原來的台詞,這就很可怕了。

這些全都是對抗樣本的功勞,我聽說視頻界的朋友希望做一個影視公司,未來可能要研究人工智能,他們的目標是以後不用人來寫劇本了,換成用AI來做編劇,甚至在未來還能做視頻、電視劇。

那麽以後我們欣賞的可能都不是人寫的了。這可能是未來的一個方向,我不知道能不能實現。

AI對抗AI會發生什麽?

大家看這個圖片裡面有什麽呢?

有一個汽車的停止的標誌。圖片裡所有元素都是用來做目標檢測。

可是請大家注意一個細節,其他的東西全部都被正確識別,只有停車標誌沒有被正確識別,它被識別成瓶子。

這個圖像來自於我們Keen舉辦的黑客大賽,展示的是在實驗環境下做的圖像識別欺騙的工作。這就是近些年我們在這個領域裡一直在研究的工作,其實我們對AI安全有很多研究。

下面是我們做的一個仿聲驗聲的項目,現在很多人家裡面有智能音箱,它會判斷主人說話,有些地方還能通過語音來識別人的身份,這些方法之所以能夠有效,都是因為它通過人工智能的方法采集了我們的指紋(聲紋)。

仿聲驗聲攻防賽

如果能用AI的方法合成聲音來對抗這種檢測能不能成功呢?

事實證明是可以的。當時我們在現場交給選手《王者榮耀》妲己的聲音樣本,讓它學習之後通過合成的方法說出一段話,這段話是在過去的聲音樣本中是不存在的。這並不是說AI算法本身存在漏洞,而是用AI的方法來合成聲音做了一個對抗。

那最明顯的AI對抗AI的方法是什麽呢?

現在無論登錄郵箱還是注冊都會有一個reCAPTCHA的一個驗證方式,比如我們12306的驗證,讓用戶選出下面哪個圖片裡面是楊冪,哪些包含人、汽車等等。

它都是為了防止人作弊,這樣的防禦手段其實是通過人工智能的方法實現的,它本質上是判斷登錄者到底是機器還是人,以防止其服務被濫用。

2017年,我們在矽谷舉辦比賽,我們的選手做了項工作,既然是機器來判斷對方是不是人,那我就做個機器模擬人,看它能不能判斷出來在這個圖片裡面有沒有楊冪,有沒有路燈,有沒有汽車,有沒有商店等等。

最後,它在一分鐘之內把所有的圖片全部識別成功,這幾乎已經代表了這種驗證機制的失敗。這是一個非常典型的用AI來對抗AI的安全問題。

另一個比賽項目可能更和貼合我們的生活,來自中國銀行的選手能夠讓機器通過學習來模仿人的筆跡。幾個月前大家應該看到新聞,有孩子買了這種機器寫作業,這樣的話可能會騙過家長。

但我們的要求更高,要求他們不能寫樣本當中的字,必須模擬出一個從來沒寫過的字。而且我們專門找了上海市做取證的筆跡鑒定師來判斷,這就是一個非常典型的圖靈測試。

最後現場稍微有點慘,我們這個人類鑒定師得分幾乎是零,他完全沒有分辨出來哪個是人,哪個是機器。

我們希望把人工智能所有暴露出來的安全問題都考察一遍。於是在去年,我們開了一個比賽叫做CAAD,希望能夠挑戰對抗樣本攻擊。

當時上海比賽的主持人是蔣昌建,我們要求選手在現場生成一張他的照片,隻對照片做非常有限的修改,來騙過系統的人臉識別,導致它分類錯誤。

而挑戰對象是亞馬遜的名人人臉識別系統,可以說是全世界最先進的了。我們也不知道,選手能不能在30分鐘之內完成。

最後,一個來自於Facebook的工程師成功了。

大家可以看到左邊那張圖片比較模糊,這就是選手加上的噪聲干擾。 很明顯,我們人類是能從這張圖裡分辨出蔣昌建的,而機器卻不能。

2018年的時候,英國的Ian Goodfellow提出了Gan,既生成式對抗網絡,它被評為可能會影響未來十大技術,這是一項非常高的評價。

對抗有什麽用呢?

先說機器為什麽能夠識別成功,因為它學習的是我們生活當中給它輸入的正確樣本,它之所以錯誤是因為我們輸入了一些這個世界上可能不存在的東西。

如果我們的機器隻學習正常的輸入,不犯錯,沒有問題,但是如果我們產生了一些世界上不可能存在的東西,這個就是Gan的價值。

Gan的本質上是有兩個對抗的東西,一個的目標是我一定要生成一個事,無限接近你。另外一個就像警察一樣,一定要把你鑒別出來,所以機器就和機器自己打架,進而實現自我提升。

這非常像Alpha Go打敗人類棋手之後,它從人類這裡已經無法繼續學習了,那怎麽辦?只有自己和自己下棋,這就是一種對抗,這就是一種成長。

所以機器成長的速度遠遠超過我們,那我們就必須了解它在什麽情況下會犯錯。

目前,AI最主要是在語音、文本、圖像這幾個領域的應用,所以今年的10月24號,我們會把CAAD比賽升級,引入聲音的對抗。看看誰能夠把鳥叫的聲音經過有限的修改,讓人類聽到的還是鳥叫,但是你可以騙過機器,讓它進行支付。

我們希望通過這些“攻擊”提升人工智能、機器學習、深度學習的安全性,這就對抗的價值所在。

編輯:王銳

校對:其奇

智力支持:上海市信息化青年人才協會

互動話題:

你印象最深刻的人工智能產品是什麽?

恭喜上周獲獎者@二非,請添加微信(ID:zaojiu16)領取獎品。

每周評論區,被zan最多的評論者,將獲得造就送出的禮品一份